- 인터넷은 우리에게 자유를 주었습니다. 저희는 자유를 얻기 위해 지식을 통합하고 체계화하고 공유합니다. 랜선 위 정글에서 살아남기 위해 저희는 시키는 일만 하는 꿀벌 대신 고객을 위해 창조하고 혁신하는 게릴라가 되겠습니다.

- 024042463

- 01032667931

- [email protected]

Yoast robots.txt 문제

[23.8.31 memo]robots.txt에서 ‘disallow : ‘처럼 URL을 지정하지 않으면 robots.txt의 disallow(크롤링 허가하지 않음) 명령는 무시됩니다. Yoast robots.txt 에서 선언된 ‘disallow : ‘는 구글 색인에 영향을 미치지 않습니다. 그러나 자신의 robots.txt의 내용을 꼭 확인해보세요. yoast가 자동 생성한 robots.txt 파일은 WP Robots Txt 플러그인을 통해 만든 robots.txt 파일에 내용을 덮어쓰기하여 WP Robots Txt 플러그인을 통해 만든 robots.txt의 내용이 안 보이게 합니다. 그러므로 아래의 도구의 파일 편집기 부분을 꼭 활용하여 아래와 같은 정상적인 robots.txt들을 만들어 주세요.

User-agent: *

User-agent: Yeti

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://www.decembling.co.kr/sitemap.xml

Sitemap: https://www.decembling.co.kr/sitemap-misc.xml

Sitemap: https://www.decembling.co.kr/post_tag-sitemap.xml

Sitemap: https://www.decembling.co.kr/category-sitemap.xml

Sitemap: https://www.decembling.co.kr/producttags-sitemap.xml

Sitemap: https://www.decembling.co.kr/productcat-sitemap.xml

Sitemap: https://www.decembling.co.kr/post-sitemap.xml

Sitemap: https://www.decembling.co.kr/page-sitemap.xml

Sitemap: https://www.decembling.co.kr/product-category/necklaces/

Sitemap: https://www.decembling.co.kr/product-category/bracelets/

Sitemap: https://www.decembling.co.kr/product-category/earring/

Sitemap: https://www.decembling.co.kr/product-category/set/

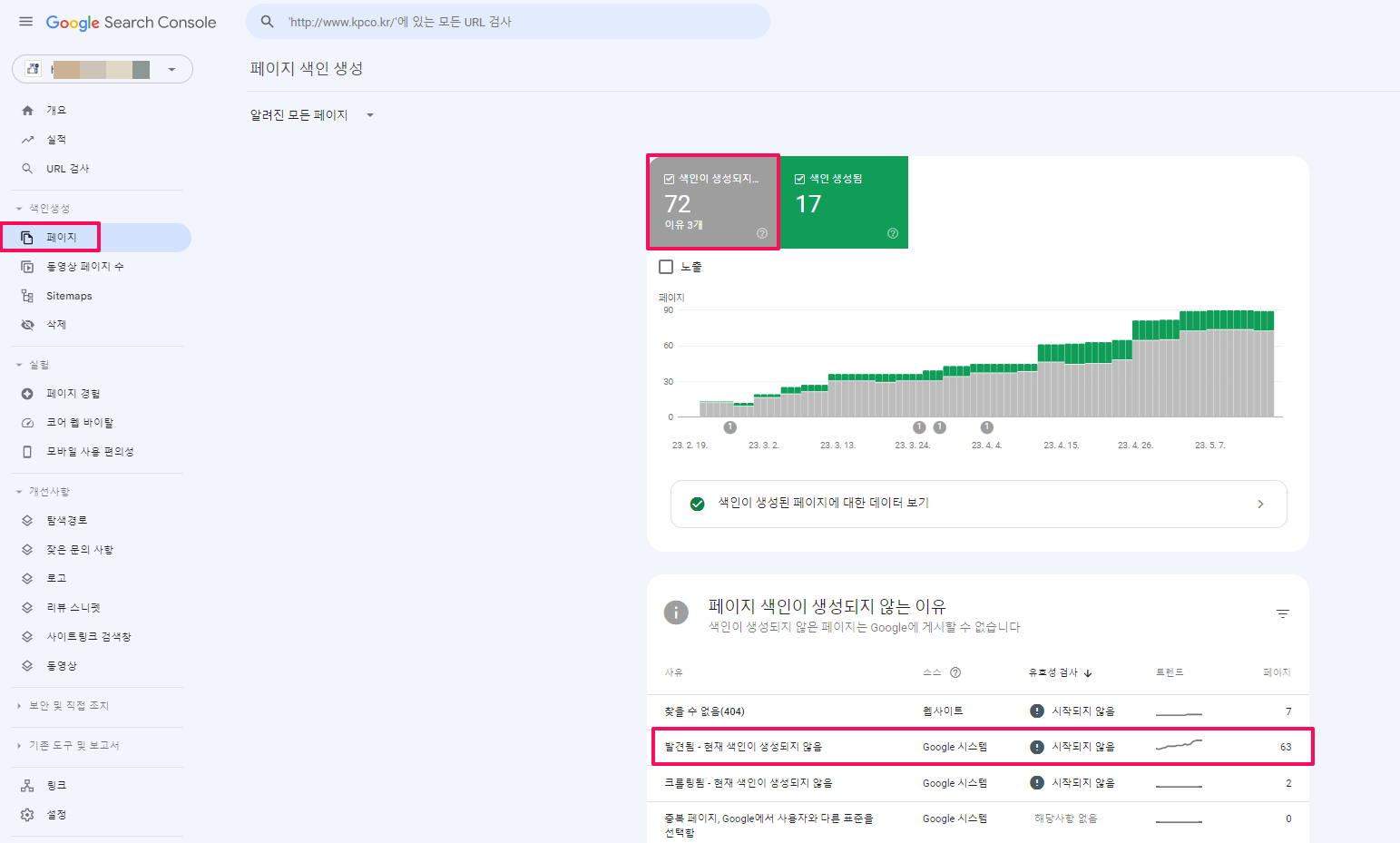

구글에서 페이지 색인인 생성되지 않는 문제

사이트를 만든지 4개월이 지났는데 구글 서치 콘솔에서 수동색인을 해준 페이지는 노출이 되는데 그렇지 않은 페이지는 색인 안되는 문제가 발생하였습니다.

참고로 모든 페이지들이 bing에서는 노출이 잘 됩니다. 이것은 구글은 robots.txt의 검색 차단 명령어(Disallow:)를 충실히 따라서 색인이 안되었고 bing의 경우에는 Indexnow를 설치하여 bing 에 URL을 자동으로 제출하여 잘 되었던 것으로 판단됩니다. 얀덱스도 살펴보았는데, 얀덱스는 구글처럼 robots.txt의 검색 차단 명령어(Disallow:)를 충실히 따라고 수동 색인 요청을 한 적이 없어 전면 페이지 1개만 노출되고 있었습니다.

원인 : yoast가 자동한 생성에 robots.txt에 의해 문제 발생

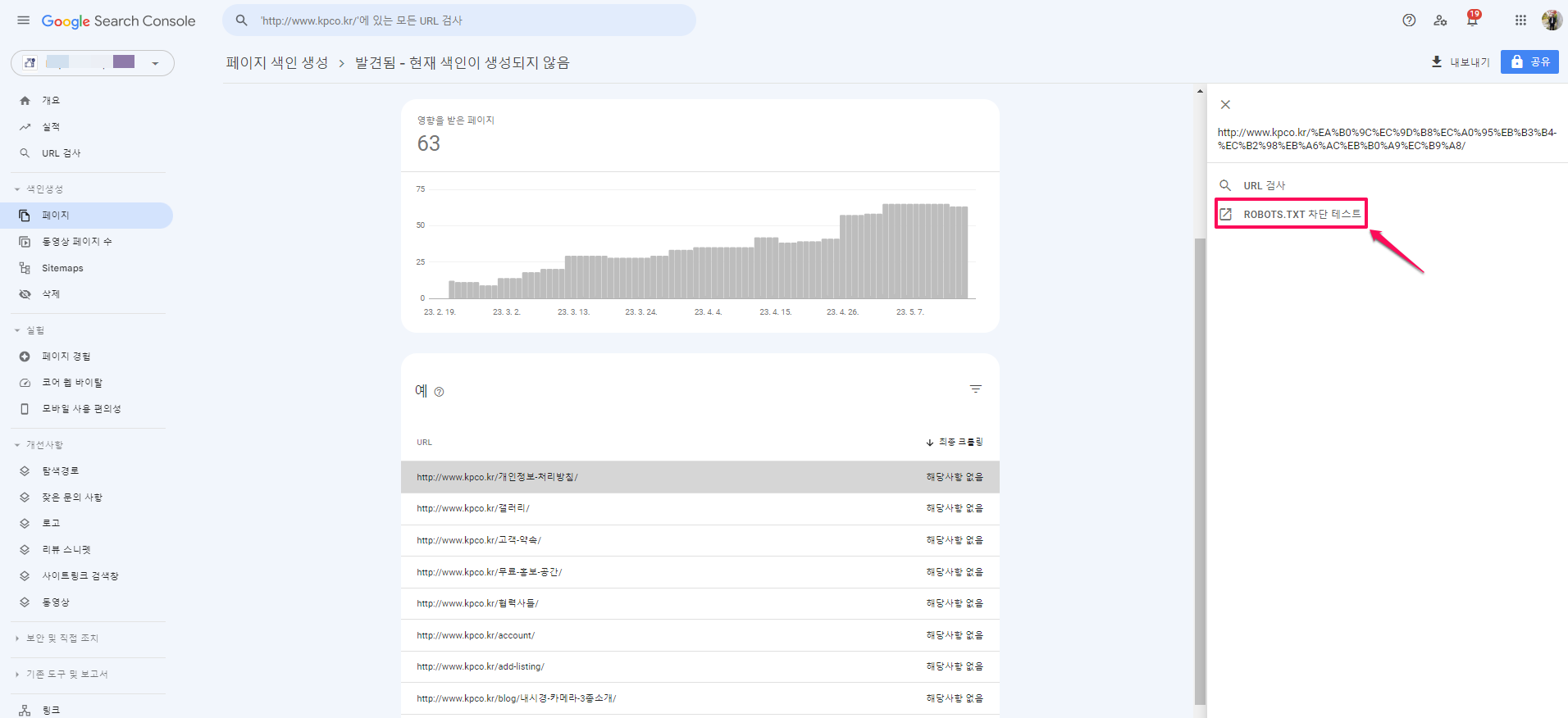

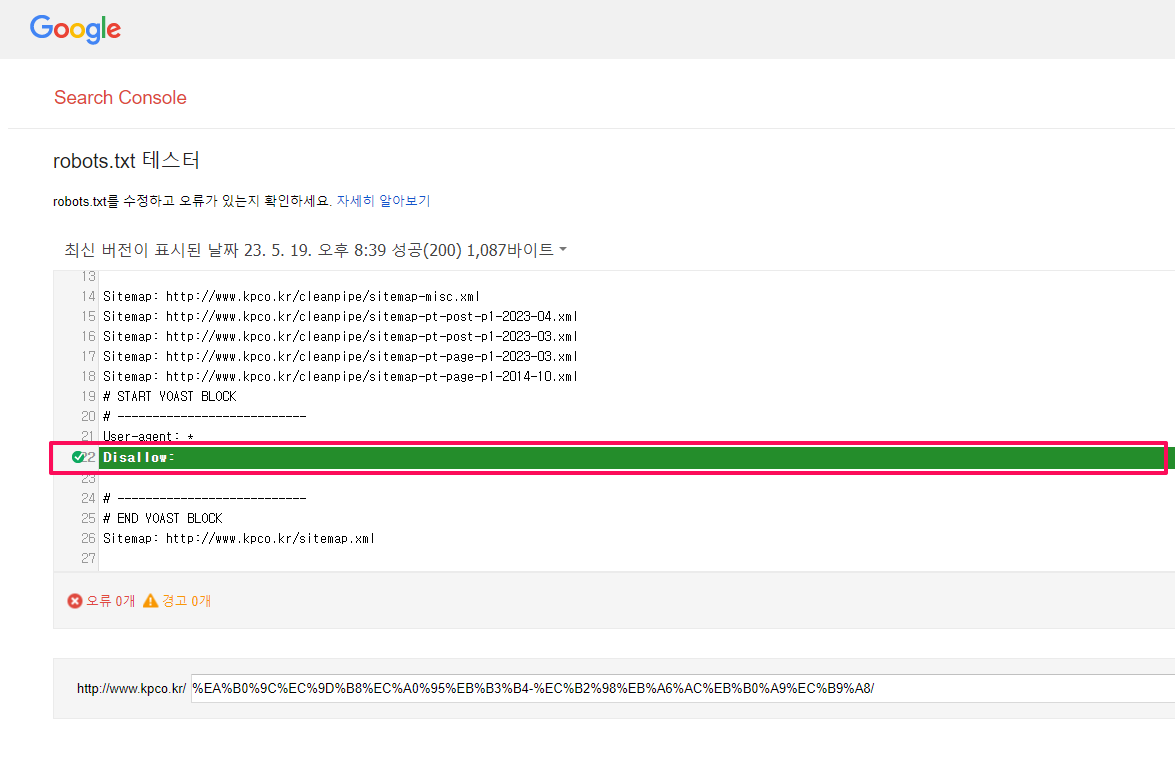

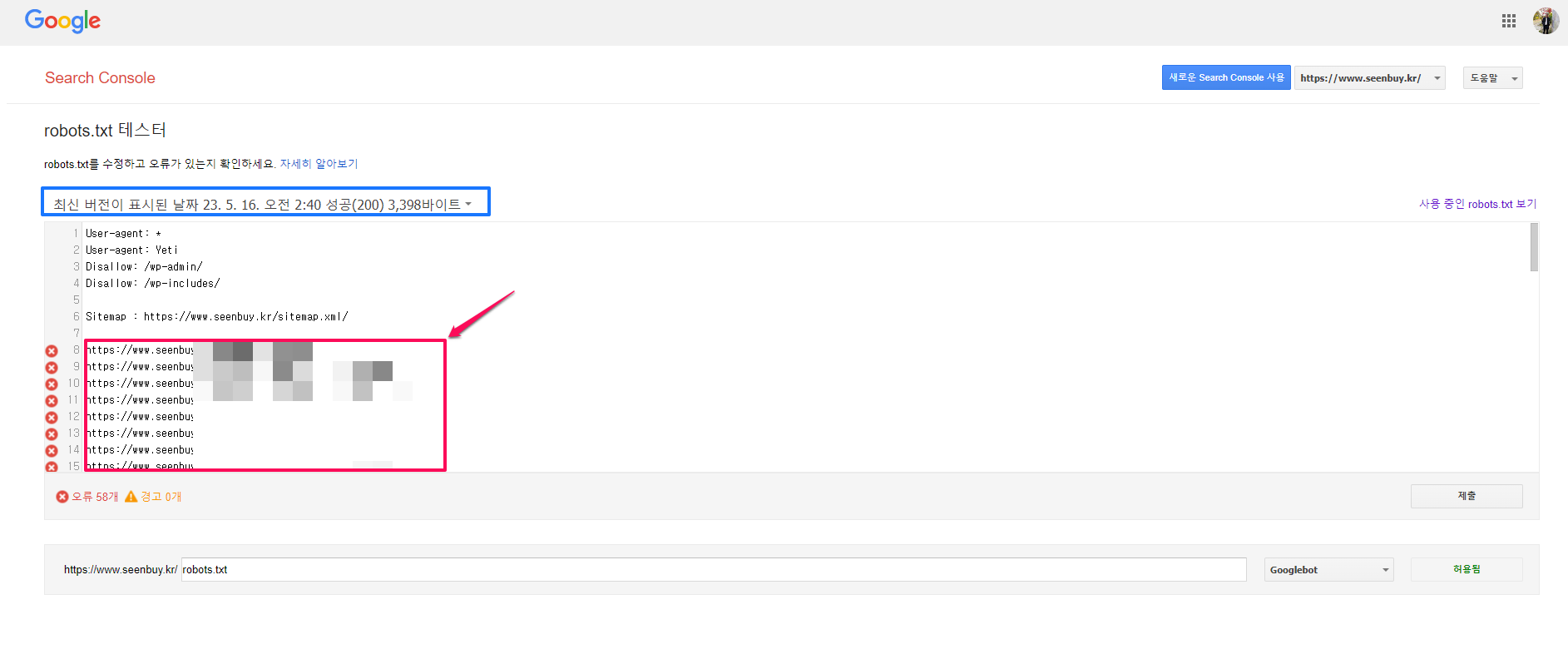

구글 서치 콘솔이 안내하는 대로 ‘Robots.txt 차단 테스트’를 클릭해 보았습니다.

아래와 같은 검색엔진 차단 명령어(Disallow: 웹사이트 전체에 대한 검색엔진의 접근을 차단한다는 명령어)가 보이며 이것은 yoast에 의해 생성되어졌음을 알 수 있었습니다.

Yoast SEO를 SEO 플로그인으로 이용하면 yoast가 자동으로 아래와 같은 robots.txt를 생성합니다.

#END YOAST BLOCK

#START YOAST BLOCK

—————————

User-agent: *

Disallow:

—————————

#END YOAST BLOCK

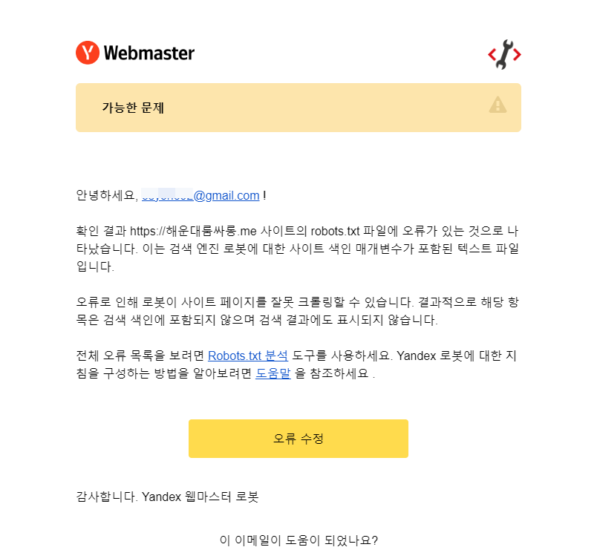

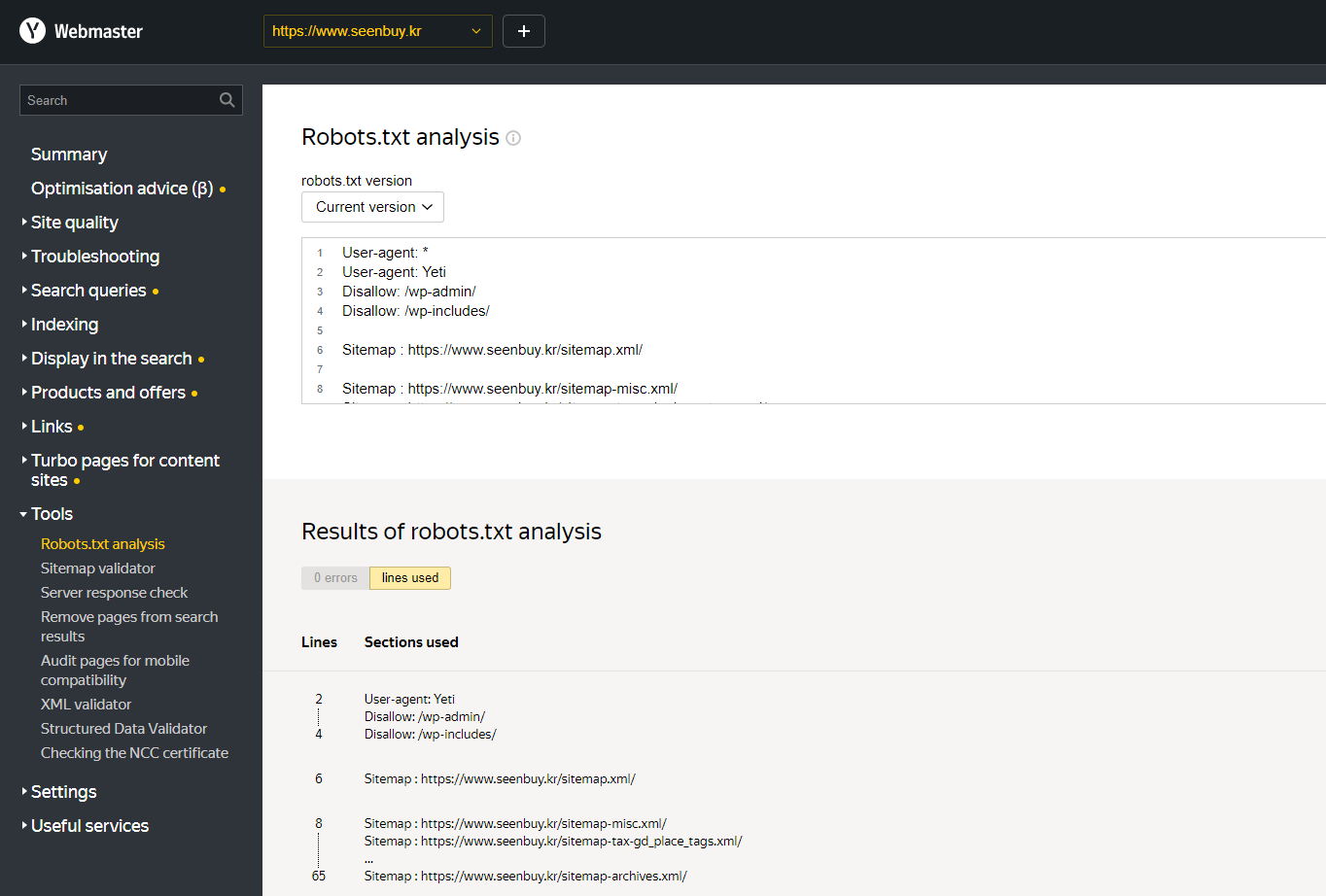

Yandex 웹마스터 도구의 에러 내용 : ‘User-agent: *’ 가 2번 선언됨

Yandex 웹마스터 도구중 Robots.txt analysis(Robots.txt 분석)는 robots.txt 분석기로 추천할만한데,

[추천]robots.txt 작성팁

Yandex 웹마스터 도구로 부터 아래와 같은 메일을 받게 되었습니다. 내용이 아래와 같이 조금은 무시무시하여 살펴보니,

오류로 인해 로봇이 사이트 페이지를 잘못 크롤링할 수 있습니다. 결과적으로 해당 항목은 검색 색인에 포함되지 않으며 검색 결과에도 표시되지 않습니다.

‘User-agent: *’ 가 2번 선언되었다는 간단한 내용이었습니다.

저희의 경우, 아래의 플러그인을 자주 이용하는데, 이 플러그인은 ‘User-agent: *’을 자동으로 선언해주는데, yoast가 ‘User-agent: *’를 자동으로 다시 선언해주어서 문제가 발생했습니다.

WP Robots Txt

WP Robots Txt 플러그인에 관해 상세 내용은 아래의 게시글을 참조하세요.

구글 서치 콘솔의 에러 내용 : 선언되지 않은 ‘Disallow:’ 문제

구글 서치 콘솔의 robots.txt 테스터에는 ‘Disallow:’에 문제가 있다고 표시되는데, 오류에는 0개로 표시됩니다. ‘Disallow:’는 뒤에 url경로가 표시되지 않았기때문에 검색엔진에 의해 무시되어지지만 가능하면 ‘Disallow:’자체를 삭제하는 것이 좋습니다.

해결방법

‘User-agent: *’ 가 2번 선언됨

해결방법은 간단합니다.

검사할 사이트를 ‘www.abc.com/robots.txt’처럼 조회하여 ‘User-agent: *’가 2번 설치되었는지 확인하고

yoast 플러그인을 SEO 플러그인으로 이용하면서 저희처럼 WP Robots Txt 플러그인을 사용하시거나 robots.txt를 직접 ftp로 올리시는 경우, 이 플러그인이나 robots.txt 파일을 작성할때 ‘User-agent: *’를 이용(선언)하지 않으시면 됩니다.

선언되지 않은 ‘Disallow:’ 문제

yoast가 생성시킨 Disallow: 를 제거해야 합니다.

Yoast SEO로 robots.txt 파일을 편집하는 방법 를 참조하여 1. yoast에서 robots.txt파일을 생성한 후 2. robots.txt파일의 내용을 모두 지운 후 저장하고 3. 파일 편집 비활성화하여 yoast가 robots.txt를 만들 수 없도록 원천적으로 막아 버리는 것입니다.

참고로 저희는 아래의 워드프레스 robotst.txt 작성 플로그인을 이용하고 있습니다.

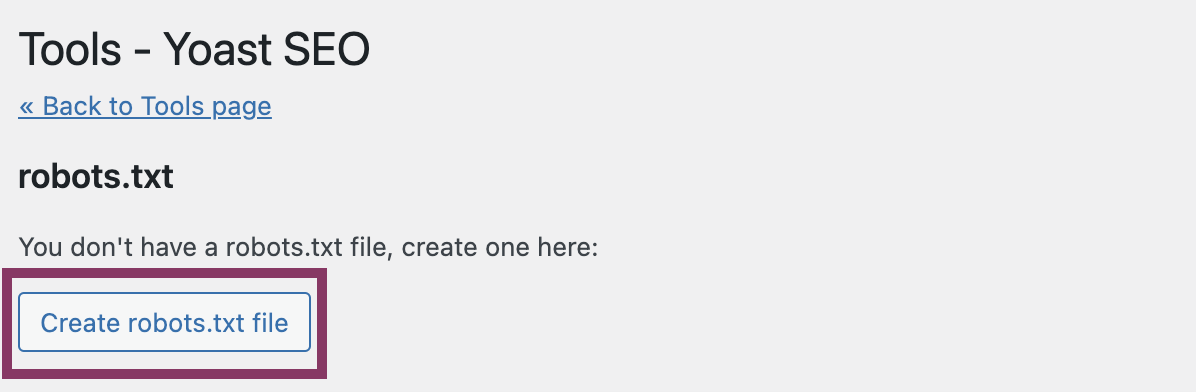

1. Yoast SEO에서 robots.txt 파일을 생성

robots.txt 파일을 생성하거나 편집하는 가장 쉬운 방법은 WordPress 대시보드에서 Yoast SEO를 이용하는 것입니다. 이렇게 하려면 아래 단계를 따르십시오.

WordPress 웹사이트에 로그인합니다.로그인하면 ‘대시보드’에 표시됩니다.

관리자 메뉴에서 ‘Yoast SEO’를 클릭합니다.

‘도구’를 클릭합니다.

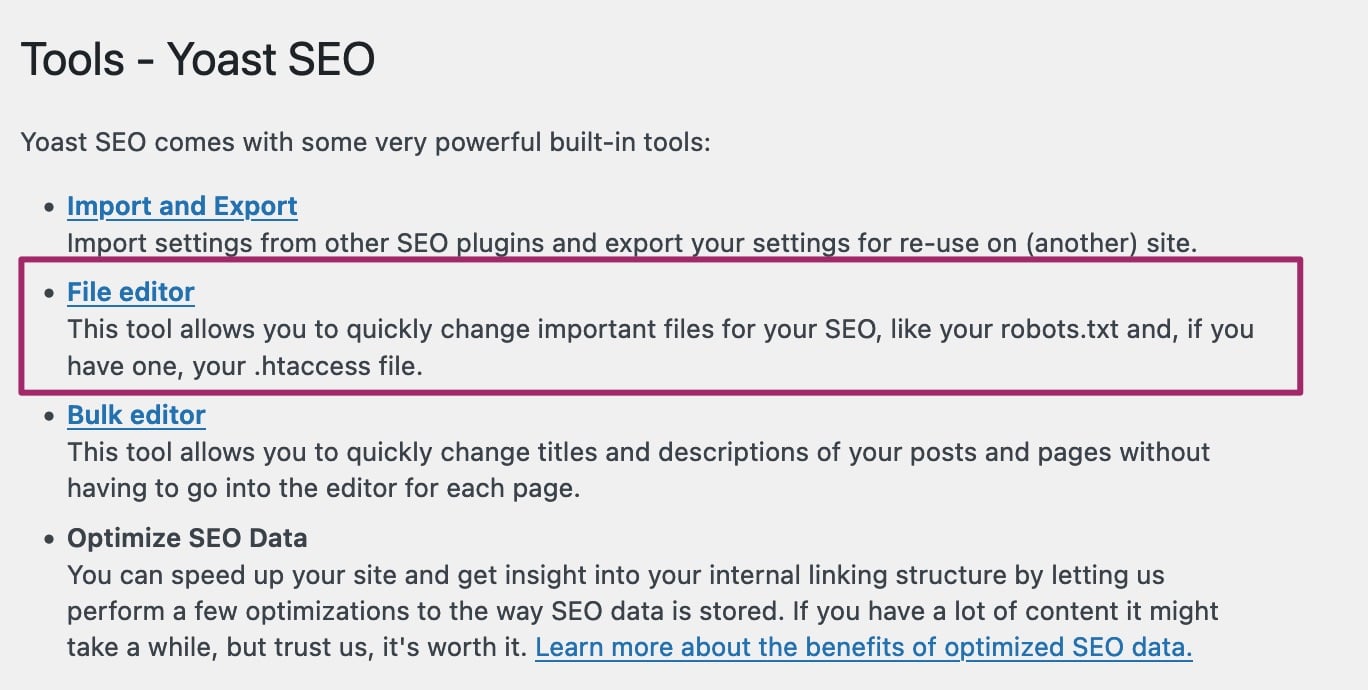

‘파일 편집기’를 클릭합니다.WordPress 설치가 파일 편집을 비활성화 한 경우 이 메뉴가 나타나지 않습니다 . 파일 편집을 활성화하거나 FTP를 통해 파일을 편집하십시오. FTP 사용 방법을 잘 모르는 경우 호스트 공급자가 도움을 줄 수 있습니다. ( 주석 : 대부분의 경우, File editor 부분이 보이지 않는 비활성화 상태입니다. 이 경우, 말 그대로 robots.txt 파일을 편집할 수 없습니다. 편집할 수 있도록 하기 위해서는 파일 편집 기능을 활성화해주어야 합니다. 이 단계는 약간의 코딩 지식이 필요합니다. 참고로 저희는 wp-config.php를 FileZilla로 다운로드한 후 Visual Studio Code로 ‘define(‘DISALLOW_FILE_EDIT’, false);’를 명령어를 추가하고 한 후 다시 FileZilla로 업로드하여 파일 편집 기능을 활성화해줍니다. )

robots.txt 파일 만들기 버튼을 클릭합니다.

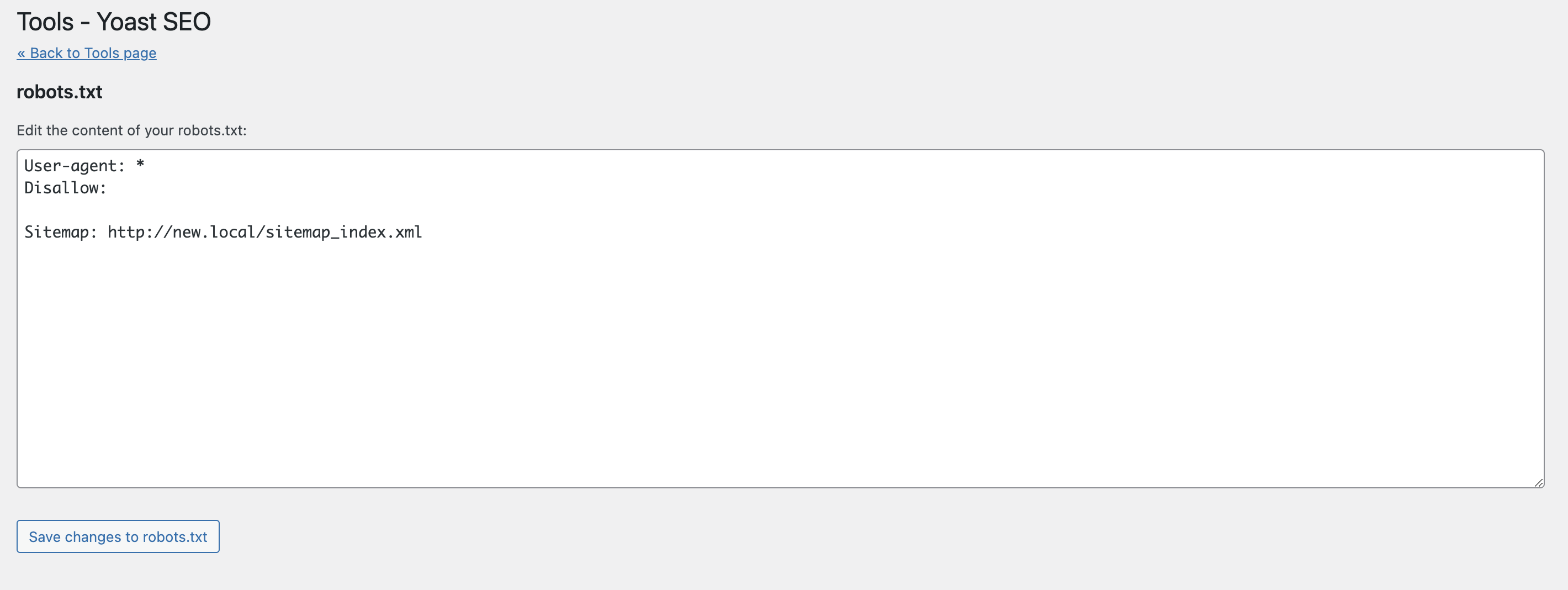

Yoast SEO에서 생성된 파일을 보거나 편집합니다.기본적으로 Yoast SEO가 파일에 추가하는 방향이 표시됩니다. 여기에서 파일을 편집할 수도 있습니다.

2. 위에서 생성한 robots.txt파일의 내용을 모두 지운 후 저장해줍니다.

3. 파일 편집 비활성화

꼭 파일 편집 비활성화하여 yoast가 robots.txt를 만들 수 없도록 원천적으로 막아주세요. 이 단계는 약간의 코딩 지식이 필요합니다. 저희는 wp-config.php를 FileZilla로 다운로드한 후 Visual Studio Code로 ‘define(‘DISALLOW_FILE_EDIT’, true);’를 명령어를 추가한 후 다시 FileZilla로 업로드하여 비활성화하고 있습니다.

WordPress 대시보드는 기본적으로 관리자가 플러그인 및 테마 파일과 같은 PHP 파일을 편집할 수 있도록 합니다. 이것은 코드 실행을 허용하기 때문에 로그인할 수 있는 경우 공격자가 사용하는 첫 번째 도구인 경우가 많습니다. WordPress에는 Dashboard에서 편집을 비활성화하는 상수가 있습니다. wp-config.php에 이 행을 배치하는 것은 모든 사용자의 ‘edit_themes’, ‘edit_plugins’ 및 ‘edit_files’ 기능을 제거하는 것과 같습니다.

define(‘DISALLOW_FILE_EDIT’, true);

이렇게 하면 공격자가 사이트에 악성 파일을 업로드하는 것을 막을 수는 없지만 일부 공격은 막을 수 있습니다.

4. yoast가 아닌 다른 방법(예: 메모장)으로 robots.txt 생성 및 ftp로 업로드하기

저희는 아래의 워드프레스 robotst.txt 작성 플로그인을 이용하고 있는데, 메모장으로 작성한 robots.txt는 이 플러그인에 우선합니다.

5. 마지막 해결 방법

Yoast SEO에서 robots.txt 파일을 생성 에서 [File editor]를 찾을 수 없어서 3. 파일 편집 비활성화 에서 define(‘DISALLOW_FILE_EDIT’, false);’로 변경하였는데 여전히 [File editor]가 안 보이는 경우, 마지막 해결 방법은 메모장으로 robots.txt를 만들어 이것을 ftp 또는 올려준후, yandex가 색인해 가도록 2주 ~ 1개월간 yoast를 비활성화해주는 것입니다.

이 방법은 다른 검색엔진(구글, 빙, 네이버, 다음 등)에는 색인이 잘 되는 경우에만 사용하세요. 국내에서 얀덱스 이용자는 적습니다. 구글, 빙, 네이버, 다음 등을 포기하며 yoast를 비활성화할 필요는 없습니다.

검증하기

robots.txt Validator and Testing Tool | TechnicalSEO.com

TechnicalSEO.com의 robots.txt Validator는 웹마스터 도구 등록 및 소유권 인증을 하는 번거로움이 없고 실시간 검증이 가능하여 편리합니다. 이것으로 검증해 주세요.

구글 robots.txt 테스터는 Yandex Webmaster의 Robots.txt analysis는 구글 서치 콘솔과 Yandex Webmaster에서 소유권인증된 자사/자신의 사이트만 검증할 수 있습니다.

구글 robots.txt 테스터를 이용해 robots.txt 테스트하기

robots.txt 테스터 도구는 robots.txt 파일이 사이트의 특정 URL에서 Google 웹 크롤러를 차단하는지를 알려줍니다. 예를 들어 Google 이미지 검색에서 차단하고 싶은 이미지의 URL을 Googlebot-Image 크롤러가 크롤링할 수 있는지를 테스트하는 데 이 도구를 사용할 수 있습니다.

robots.txt 테스터 도구에 URL을 제출할 수 있습니다. 그러면 이 도구가 Googlebot처럼 작동하여 robots.txt 파일을 확인하고 URL이 제대로 차단되었는지 확인합니다.

구글 robots.txt 테스터는 실시간 검증이 아닙니다. 아래의 이미지는 23.05.20에 실행하였는데 아래의 이미지의 파랑색 네모안을 보면 구글이 최근에 들여다 본 5.16 오전 02:00의 robots.txt를 테스트합니다. 맨 아래줄에 robots.txt 경로를 입력하고 [Test]를 눌러 Test해주셔야 합니다.

Yandex Webmaster의 Robots.txt analysis로 검증하기

Yandex Webmaster를 이용하고 계시다면 [Tools] -> [Robots.txt analysis]를 통해 검증할 수 있으며 Yandex Webmaster의 경우 실시간 검증이 가능합니다.

참고자료 : 1. Use robots.txt and .htaccess rules to control crawling and indexing